AIを支える、大規模言語モデル(LLM)の基本的な動作原理は、自己回帰モデルに基づく次の単語を予測する仕組みであるといえます。

この原理は、LLMの驚異的な能力の基盤であると同時に、その活用戦略を考える上で理解すべき重要な限界をも示しています。

以下に、この「次単語予測マシン」としての動作原理の詳細と、それが活用戦略に及ぼす影響について説明します。

I. 動作原理:次単語予測の仕組み

大規模言語モデル(LLM)は、基本的にただ 「次に来る単語(トークン)を予測している」 だけの、大規模な言語モデルです。この動作原理だけで、人と区別するのが難しいほど流暢に言葉を話す能力を発揮することは、専門家にも大きな衝撃を与えました。何千億、兆という単語の並びを学習した経験から得られた成果といえます。

この記事は7,790語、読了時間はおそよ20分程度。

動画で、9分26秒にまとまっているのでこちらを先に見ることをおすすめします。

I. 動作原理:次単語予測の仕組み

大規模言語モデル(LLM)は**自己回帰型モデル(autoregressive model)と呼ばれる仕組みに基づいて動作します。

これは、文章をトークン(単語・文字・記号などの単位)に分割し、「直前の文脈をもとに次に出るトークンを予測する」**という単純な原理に従っています。

たとえば、「私は今日〇〇へ行きました」という文を生成するとき、

モデルは以下のように逐次予測を繰り返しています:

「私は」 → 次に来る単語は「今日」か?

「私は今日」 → 次は「学校」か「会社」か?

「私は今日会社」 → 次は「へ」か?

「私は今日会社へ」 → 次は「行きました」か?この単純な操作を数千億回規模の文脈学習と確率予測の積み重ねで行うのが、LLMの本質です。

🔹 仕組みの核心

- 学習段階(pre-training)

膨大なテキストデータを用い、単語列の統計的な関係を学習します。

モデル内部では「重み」と呼ばれるパラメータが数千億個単位で最適化され、

「文脈から意味を推定する能力」が形成されます。 - 生成段階(inference)

入力文の後に来る最も自然な次トークンを、確率分布から選び取ります。

確率的サンプリングを行うことで、同じ質問にも異なる自然な回答を生成できます。 - 自己回帰的生成

生成したトークンを文脈に追加し、次の予測を再び行う——

この「予測→追加→再予測」の繰り返しで文章全体を作り上げます。

II. 限界と活用戦略への示唆

LLMが「次単語予測マシン」であるという事実は、

驚異的な表現能力と、構造的な限界を同時に意味します。

1. 強み

- 自然言語の流暢な生成(構文・文法・語彙の統計的再現)

- 多様な知識の再構成(百科事典的知識や会話の模倣)

- 推論的な言語パターンの学習(「こう言われたらこう答える」的連想)

2. 限界

- 「理解」や「意図」はなく、統計的な模倣に過ぎない

- 真偽や論理整合性の保証ができない(幻覚=hallucination)

- 状況依存の判断や感情理解が、確率的推測にとどまる

3. 活用戦略のポイント

LLMを活かすためには、

「言語的知能(生成)」と「構造的知能(検証・制御)」を組み合わせることが重要です。

- 制約とルールの導入:プロンプト設計・チェーン・外部知識の活用(RAGなど)

- 評価と検証の仕組み:AI出力をチェックする自動化プロセス

- タスク分割:単一LLMで完結させず、分業(例:生成AI+解析AI)

1. 自己回帰モデルと条件付き確率

LLMの動作は、自己回帰モデルによってモデル化されます。これは大雑把に言えば「こう来たら、そう返すよね」という人間の知識を確率モデルで表したものです。

• 条件付き確率の算出:LLMは、入力された文脈(前振り)に基づいて、次に来る単語系列の列挙と、それぞれの発生確率を算出する能力を持っています。

• トークンと文脈:LLMはテキストを「トークン」というごく短い単位に分解して処理します。LLMは、先行するトークン列に対して、次に続くトークンが何かを条件付き確率で算出します。

• 学習の目的:LLMは、事前学習において、この条件付き確率が最大となるようにニューラルネットワークを構築することを目指しています。これにより、生成される単語系列全体が「そう返すよね」と思えるような、自然なトークン列を生成できるようになります。

2. 生成とデコーディングのプロセス

具体的な文章生成のプロセスは、トランスフォーマーと呼ばれるニューラルネットワーク構造を中核として進行します。

1. トークン化と埋め込み:入力テキスト(プロンプト)はトークンに分割され、各トークンは数百次元の数値ベクトル(埋め込み)に変換されます。

2. 自己注意機構:デコーダは、文脈を理解するため、各トークンが文章中の他のトークンとどれだけ関連しているかを計算する**自己注意機構(セルフアテンション)**を使用します。

3. 確率分布の生成:デコーダが生成した生の数値ベクトル(ロジット)は、ソフトマックス関数に通され、語彙中のすべての単語に対する「確率分布」に変換されます。これは、各単語が次に生成される可能性を示します。

4. 単語の選択:この確率分布から、実際に「どの単語を選ぶか」が**サンプリング戦略(デコード方式)**によって決定されます。

3. 出力制御のためのサンプリング戦略

LLMがただの「予測マシン」でありながら多様な応答ができるのは、次の単語の選択に確率的な揺らぎを持たせることができるためです。

• Greedy Decoding(貪欲法):常に最も確率の高い単語を選ぶ方法で、高速で一貫性がありますが、創造性や多様性に欠けます。定型的な診療記録の生成などに適しています。

• Beam Search(ビームサーチ):複数の選択肢を同時に考慮し、多様性と品質を向上させますが、計算量が増えます。複数の診断結果を検討する場面などに適しています。

• Random Sampling(ランダムサンプリング)/ Top-k / Top-p:確率に基づいてランダムに単語を選ぶ方法で、創造性や多様性を高めます。

• Temperature(温度):確率分布の「鋭さ」を調整するパラメータです。低い値(例:0.5)では確率の高い候補に集中し堅実になり、高い値(例:2.0)では確率が均等化して珍しい単語も選ばれやすくなります(創造的だが暴走しやすい)。

II. 活用戦略:予測マシンの強みと限界への対応

LLMの能力は「次の単語を予測する」というシンプルな原理に立脚しているため、活用戦略は、このメカニズムの特性を理解し、その限界を克服することに焦点を当てます。

1. 予測マシンの限界

賢く見えても「次の単語予想マシン」であることに起因する、いくつかの不得意が存在します。

• 論理的推論の困難さ:LLMは、膨大なデータからの統計的パターンマッチングに基づいて推論しますが、明示的な論理規則を自ら創出・適用することはできず、根本的な因果関係や論理的整合性の検証を行いません。このため、学習データにない状況での汎化能力や厳密な論理展開に限界があります。

• ハルシネーション(幻覚):事実に基づかない内容やデタラメな情報が含まれる現象です。これは、LLMが「本質を知らないまま、次に来る確率が高いトークンを生成する」という自己回帰モデルの動作の限界によって起こります。

• 論理の飛躍と暴走:LLMは論理の飛躍に弱く、一度間違った出力を確定すると、それを前提として次の単語を生成するため、そのまま暴走してしまう傾向があります。

• 「思考」順序の制約:LLMは次の単語の出力に集中するため、人間のように「まず該当箇所を探して、そこから前に戻って(Prefixを)得る」といった、出力順序に逆らったタスクを苦手とします。

2. 活用戦略:予測プロセスを制御する

LLMの限界を克服し、正確に働いてもらうためには、LLMの「思考」の順序に沿う形でタスクを設計してあげることが重要です。

• Chain-of-Thought (CoT) プロンプティング:これは、複雑な推論タスクにおいてLLMの性能を高める強力なテクニックです。CoTは、最終的な答えに到達する前に、中間的な推論ステップを段階的に生成するようモデルに促します。

◦ ゼロショットCoT:特に「Let’s think step by step」(ステップ・バイ・ステップでアプローチしてみましょう)という簡単なプロンプトを与えるだけで、LLMに多段階の論理的な推論を行わせる可能性が示されました。

◦ このアプローチは、複雑な問題をより小さなステップに分解し、エラーの伝播を減少させることで、問題解決の精度と解釈可能性を向上させます。

• プロンプト設計の最適化:LLMの出力順序を、モデルの順次予測に有利なように変更する(例:prefix → matchではなく、match → suffixの順序にする)ことで、タスクの安定性が向上します。

• タスク分担:LLMには大量のテキスト生成やデータ解析、要約などの情報生成や初期分析を任せ、人間が創造的な判断や倫理的評価、最終調整を担うという戦略が効果的です。

LLMが「次の単語予測マシン」であることを意識し、その予測プロセスを適切に制御(プロンプトエンジニアリングやデコード戦略の選択を通じて)することで、LLMを上手に活用し生産性を向上させることができます。

例え話による補足:

LLMが「次単語予測マシン」であることは、まるで非常に速く、流暢で、膨大な知識を持つ「連想ゲームの名人」のようなものです。

この名人は、「今日の天気は」と聞かれたら、「晴れです」という、次に続く確率が最も高い言葉を瞬時に選びます。しかし、名人は言葉の意味や因果関係を本当に理解しているわけではありません。彼にとって「晴れです」は、過去の膨大な会話データの中で「今日の天気は」の後に続く確率が最も高かったトークンの並び(パターン)に過ぎないのです。

もし複雑な論理パズルを出された場合、名人は答えの言葉が流暢に聞こえるように、単語を順番に選んでいってしまいます。このとき、論理的な手順を踏まずにいきなり結論の言葉を連想しようとすると、途中で辻褄が合わない(ハルシネーション:幻覚)が発生します。

CoT(思考の連鎖)プロンプティングとは、この名人に「結論を出す前に、頭の中で何を考えたかを言葉にして順番に言ってごらん」と指示することに相当します。これにより、名人は「次に来る確率が高い言葉」を段階的な思考プロセスとして生成することになり、結果として論理の誤りや飛躍を防ぎやすくなるのです。

制御技術(CTG)による予測動作の調整

制御可能なテキスト生成(CTG: Controllable Text Generation)技術は、LLMの出力が安全性、感情、テーマの一貫性、言語スタイルなどの事前に定義された制御条件に従いながら、高い有用性、流暢さ、多様性を維持することを保証します。これらの技術は、LLMの「次の単語予測」プロセスに介入し、その出力結果を意図する方向に導きます。

主な制御技術は、デコーディング時の介入(サンプリング戦略) と プロンプトエンジニアリング(思考プロセスの誘導) の二つに大別されます。

1. デコーディング時の介入:確率分布からの単語選択の制御

デコーディング方式(サンプリング戦略)は、LLMがソフトマックス層で算出した確率分布から、実際に次に生成する単語(トークン)を決定する方法であり、予測の**「創造性」や「一貫性」**を直接制御します。

| 制御手法 (Decoding Strategy) | 予測への影響 (目的) | 応用例 | 関連原理 |

| Greedy Decoding(貪欲法) | 常に最も高い確率の単語を選ぶ。予測の一貫性と高速性を優先。 | 定型的な診療記録やレポートの生成。 | 確率分布の中で最大値を選択。 |

| Beam Search(ビームサーチ) | 複数の選択肢を同時に考慮し、多様性と品質を向上させる。 | 複数の診断結果を同時に検討する場面。 | 計算量が増えるが、全体的な品質を担保。 |

| Random Sampling / Top-p / Top-k | 確率に基づきランダムに単語を選ぶことで、創造性や多様性を高める。 | 多様な対話システムや新しい治療法の提案。 | 累積確率や上位候補の中からランダムに選択。 |

| Temperature(温度) | 確率分布の**「鋭さ」を調整**する。低い値では堅実、高い値では珍しい単語を選びやすくする。 | 創造性が必要なブレインストーミング(高T)や正確性が必須の事実確認(低T)。 | ソフトマックス関数内のロジットを割ることで確率分布を調整。 |

これらのデコーディング技術は、**「確率分布に基づいて単語を選んでいる」**というLLMの基本原理を操作し、単調な出力を避けたり、目的(例:医療分野の正確性や一貫性)に応じて出力の性質を変化させたりするために用いられます。

2. プロンプトエンジニアリング:思考プロセスの誘導

プロンプトエンジニアリングは、LLMの**「次の単語予測」の順序と内容を、より論理的かつ正確な方向に誘導する**ための制御技術です。

• 思考連鎖(Chain-of-Thought: CoT)プロンプティング: CoTは、複雑な推論タスクにおいて、LLMに最終的な答えを出す前に、中間的な推論ステップを段階的に生成するよう促す手法です。これは、LLMが論理の飛躍に弱いという「次の単語予測マシン」の限界を克服するために開発されました。

◦ メカニズム:LLMは、次の単語を順番に予測していくため、プロンプトで「ステップ・バイ・ステップで考えよう」(Let's think step by step)と指示されると、論理的な思考プロセス自体をトークン系列として生成することになります。このプロセスが、複雑な問題を小さなステップに分解し、エラーの伝播を減少させることで、精度を大幅に向上させます。

◦ 成功例:特にゼロショットCoTは、追加の例なしに、LLMに多段階の論理的な推論を行わせる可能性を示し、数学的な推論タスクの正答率を飛躍的に向上させました。

• タスク設計の最適化: LLMが「思考」の順序に逆らったタスクを苦手とするため、活用戦略としては、LLMの自己回帰的な出力順序に沿う形でタスクを設計し直すことが重要です。

◦ 実例:特定のテキスト箇所を抜き出す際、LLMが苦手とする「該当箇所から前に戻る」(prefixを先に生成する)順序ではなく、LLMの予測の順方向である「該当箇所の後ろのテキスト」(suffix)を生成する順序にJSONフォーマットを変更することで、タスクの遂行精度と安定感が向上することが示されています。

III. まとめ

LLMの基本原理である「次の単語予測」は、入力された文脈に対する統計的に最も尤もらしいトークン系列を生成します。

制御技術は、この確率的な予測プロセスに対して、外部から具体的な制約や誘導を加えることで、予測の方向性(プロンプトエンジニアリングによる論理性の確保) や 予測の性質(デコーディング戦略による創造性・一貫性の調整) をコントロールし、実世界の複雑な要件や信頼性基準を満たすように機能します。

制御技術は、単に「流暢な言葉」を生み出すLLMを、特定の目的を達成するための「信頼できるツール」へと変貌させるための架け橋と言えます。

III. 実践応用:LLMの限界を超えるアーキテクチャ

大規模言語モデル(LLM)は、単体では「確率的に次の単語を予測するだけの装置」です。

しかし、これを外部の知識・道具・記憶・目的構造と組み合わせることで、

初めて「思考」「判断」「行動」を模倣する“知能アーキテクチャ”として機能します。

この章では、その代表的な3つの拡張手法を解説します。

1. RAG(Retrieval-Augmented Generation)

= 検索拡張生成:記憶を外に持つLLM

🔹 仕組み

LLMが回答を生成する前に、外部データベース(例:企業文書・議事録・マニュアルなど)から

関連情報を検索(Retrieve)し、文脈として与えてから生成(Generate)する構造です。

ユーザー質問 → 検索 → 文脈抽出 → LLMに提示 → 回答生成🔹 効果

- 最新情報・専門知識を反映できる

- 幻覚(hallucination)を大幅に抑制

- LLMの“理解しているように見える”能力を実務レベルへ拡張

🔹 活用例

- 社内ナレッジ検索AI

- 製品マニュアルQA

- 議事録分析・要約(→あなたのプロジェクトでも活用)

2. Tool Use(ツール使用)

= 外部機能を呼び出して行動するLLM

🔹 仕組み

LLMは、文章を生成するだけでなく、API・関数・プログラムを呼び出すことができます。

これは「次単語予測」という制約を逆手にとり、

「次の単語=関数呼び出し構文」として出力させる手法です。

「ユーザーが指定した都市の天気を調べる」

→ LLMは内部で次のように出力:

call(weather_api, { city: "Tokyo" })🔹 効果

- 推測ではなく実際のデータを取得可能

- 計算・検索・データ処理などをAIが自動実行

- LLMを「操作の中心」に据えた自律システム構築が可能

🔹 活用例

- LaravelやPythonなどのコード自動生成

- 売上データの解析・グラフ作成

- 外部API連携(Google Calendar, Stripe, etc.)

3. Agent(エージェント構成)

= 目的を持ち、判断・分岐・行動するLLM群

🔹 仕組み

エージェントとは、「目標を与えられたLLMが、自ら思考し、必要な行動を選択する」構造です。

その中核は「計画 → 行動 → 評価 → 再計画」のループです。

目的:ユーザーの課題を整理して提案書を作成する

↓

(1) 課題ヒアリング → (2) 情報収集 → (3) ドキュメント生成 → (4) 検証・修正 → 繰り返し🔹 効果

- 一回の指示ではなく、プロセスを通じた成果を出せる

- 複数の専門エージェントを連携させることで「仮想チーム」が構築可能

- 企業の業務自動化や教育分野で急速に活用が進行中

🔹 活用例

- AIコンサルタント(課題発見 → 解決提案)

- AIプロジェクトマネージャ(タスク分解 → 進捗管理)

- AIエンジニア補助(要件定義 → 設計 → コード生成 → テスト)

4. 設計思想としての「LLMオーケストレーション」

LLMの出力を“そのまま使う”段階から、“構成する”段階へ進むには、

次のような設計思想が重要になります。

| 項目 | 目的 | 代表技術 |

|---|---|---|

| 記憶(Memory) | 過去の会話や履歴を保存し文脈を継続 | ベクトルDB・pgvector |

| 知識(Knowledge) | 外部データを参照して補完 | RAG・外部検索 |

| 行動(Action) | 実際のAPI呼び出し・操作 | Tool use・function calling |

| 目標(Goal) | 目的志向でタスクを遂行 | Agent・Planner構造 |

最新のお知らせ

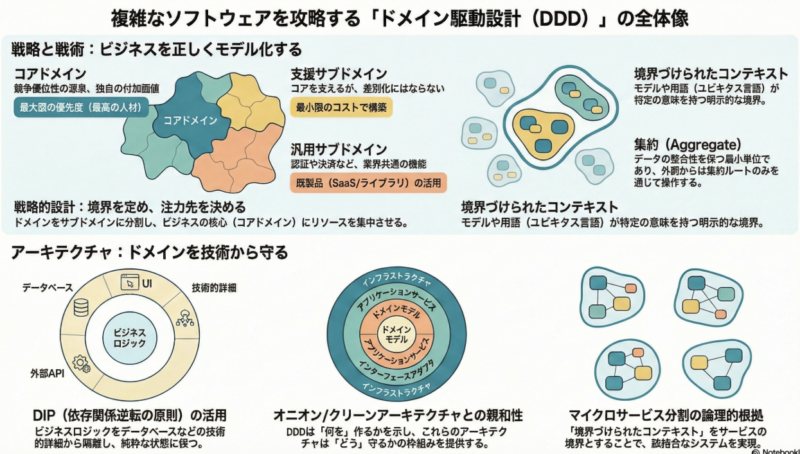

なぜDDDは「オニオン」や「クリーン」とセットで語られるのか?現場で役立つ5つの本質的教訓

1. はじめに:私たちはなぜ「DDD難民」になってしまうのか...

UNIXとC言語の誕生

1969年に、デニスリッチーはケン・トンプソンと共に、ベル研究...

2026 AI企業のこれからを予測してみよう

2026年、AI企業は「技術の凄さ」を競う段階から、「社会のイン...

DeepSeek、Moonshot AI、MiniMaxの3社が偽アカウント2.4万超を作って、Claude1600万回以上不正使用

いや、本当にえぐいニュースですよね。巨額の資金と時間を...

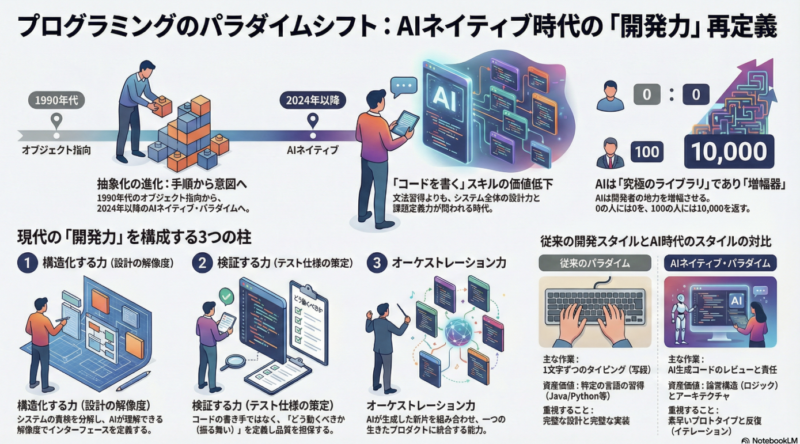

プログラミング・パラダイムシフト

プログラム、プログラミングという世界は10年に1度くらいでパラ...

ヨハン・セバスチャン・バッハ の世界

ヨハン・セバスチャン・バッハ の世界 SUNOでクラシカル...

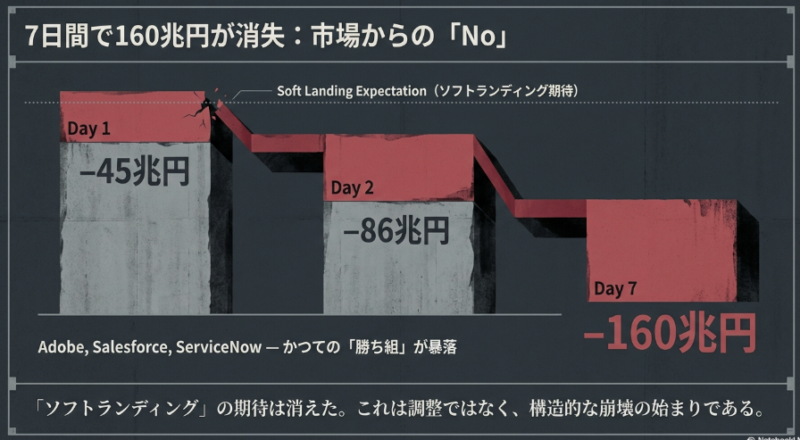

【SaaS全滅】時価総額160兆円が消失したSaaSapocalypseの全貌と市場構造の激変

SaaSapocalypse サース・アポカプリス さーす・あぽかぷりす...

ダーツについて調べてまとめてみました

久しぶりに知っている営業から電話があったので、キーワードを...

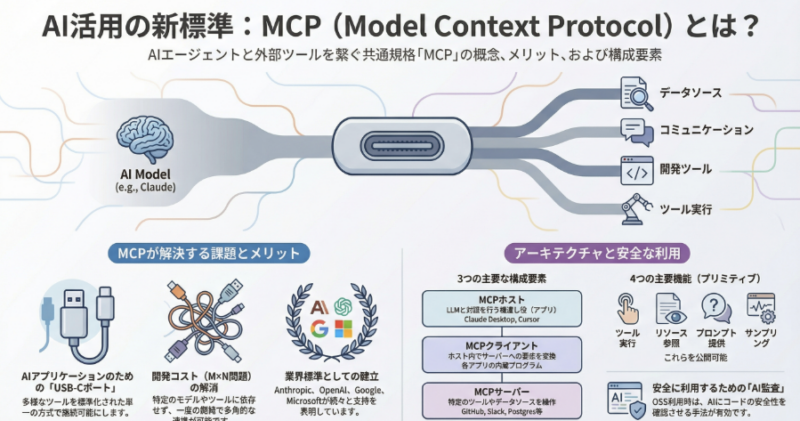

AIエージェントの「USB-C」:Model Context Protocol(MCP)が変える未来

AI活用の新標準:MCP解説 1. イントロダクション:...

2026年版:ローカルコンテナの中に、自分だけのAI環境を構築したい

ローカルコンテナ(Docker)を使って自分だけのAI環境を構...