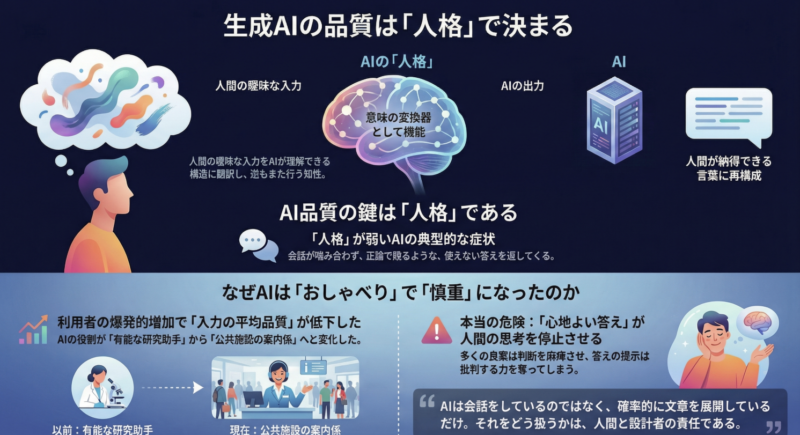

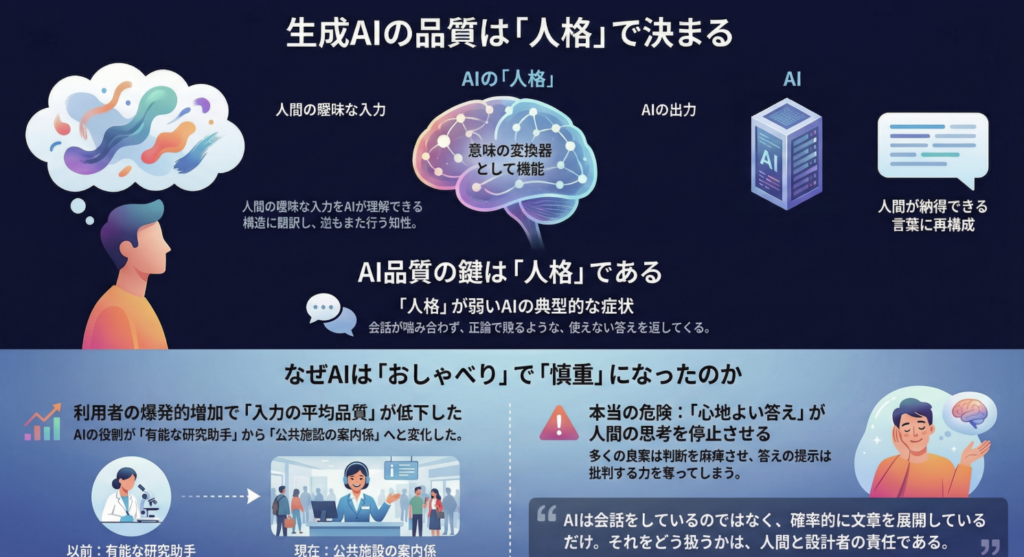

本ブリーフィングは、生成AIの品質と進化に関する一連の分析を統合したものである。中心的な論点は、AIの品質が基盤となるモデルの性能ではなく、人間とAIの対話を仲介する「チャット係の人格」という設計された知性によって決定されるという点にある。この「人格」は、人間の曖昧な入力をAIが理解できる構造に翻訳し、AIの論理的な出力を人間が納得できる言葉に再構成する「意味の変換器」として機能する。

近年の生成AIが、意図的に即答を避け、確認や質問といった「過剰なやりとり」を増やす傾向にあるのは、この人格設計が成熟した結果である。その背景には、利用者の爆発的な増加に伴う入力品質の低下と利用前提の多様化(非対称化)がある。AIは「有能な研究助手」から、事故防止を最優先する「公共施設の案内係」へとその役割を変質させざるを得なかった。この変化は、AIが「速く答える存在」から「間違えずに答える存在」へと舵を切ったことを示している。

この状況下で、高度利用者は従来のチャットUIから、APIやワークフローを通じてAIを「設計する側」に回ることで、その能力を最大限に引き出す経路を確保している。人格の切り替えは、ユーザーの自己申告ではなく「入力品質」をトリガーとすることで技術的に可能であり、これが今後のAIを利用したシステム設計の主流となる。

最終的に、AIがもたらす最も深刻なリスクは、誤った情報を生成することではなく、心地よい応答を通じて人間の「疑う能力」や批判的思考を麻痺させることにある。良質な案の過剰な提示は選択麻痺を引き起こし、思考の放棄につながる。生成AIは会話をしているのではなく、確率的に文章を展開しているに過ぎない。この本質を理解し、AIに判断を委ねず、その限界を明確に定義する設計思想こそが、AIとの健全な共存を実現するための鍵となる。

--------------------------------------------------------------------------------

1. 生成AIの品質を決定する「人格」という概念

生成AIの品質評価において、モデル自体の性能以上に決定的な要素が存在する。それは、人間とAIの間に立ち、対話を仲介するインターフェースの知性、すなわち「チャット係の人格」である。

結論から言うと―― 生成AIの品質を決めているのはモデルではなく、 人間とAIの「あいだ」に立つ“チャット係の人格”である。

1.1. 「人格」の定義:意味の変換器

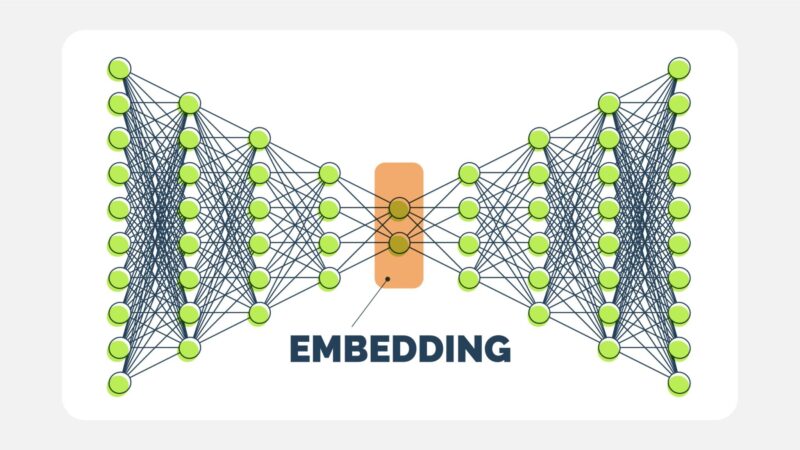

ここで言う「人格」とは、感情やキャラクター設定ではなく、人間とAI間のコミュニケーションを成立させるための「調停者」としての機能的役割を指す。これはUIでもLLMそのものでもなく「設計された知性」である。

- 人間からAIへ: 人間の曖昧・感情的・断片的な入力を解釈し、AIが処理可能な構造化された情報へと翻訳する。

- AIから人間へ: AIの論理的・確率的・非人間的な出力を、人間が納得できる意味や文脈を持つ言葉へと再構成する。

このプロセスは、人格が人間とAIの“意味の変換器”として機能していることを示している。

1.2. 「人格」の重要性

人格がAIの品質に直結する理由は、人間とAIの根本的な特性の違いに起因する。

| 課題 | 説明 |

| 人間の入力は常に壊れている | 人間の入力は、主語の欠落、感情の混入、目的の変化、言語化の不完全さなど、構造的な欠陥をほぼ常に含んでいる。これをそのままAIに渡すと、AIは“正確にズレた答え”を生成してしまう。人格はここで「ユーザーが本当に何を聞きたいのか」を代行理解する役割を担う。 |

| AIの出力は人間に冷たすぎる | AIの出力は、論理的に正しくても、配慮や文脈を欠き、正論で利用者を圧倒したり、不要な情報を大量に含んだりすることが多い。これをそのまま提示すると、利用者は「このAIは分かっていない」と感じる。人格はここで、出力に意味、温度感、適切な順序を与える調整役となる。 |

1.3. 人格の強度によるAIの挙動の違い

人格の設計レベルは、AIの対話品質に直接現れる。

| 人格が弱いAIの典型症状 | 人格が強いAIの特徴 |

| 聞いていない説明を延々と続ける | 「そこが知りたいんですね」とユーザーの意図を言語化する |

| 質問の前提を理解していない | 情報量を自律的に最適化する |

| 正しいが、実用性に欠ける | 人間の思考速度に合わせる |

| 会話が噛み合わず、人間側が疲弊する | 話が逸れた場合に自然に本筋に戻す |

| ユーザーに「考えが整理される感覚」を与える |

本質的に、「生成AIの知性は、人格というフィルタを通して初めて、人間の知性として立ち上がる」のである。この人格は、UIの文言、プロンプト、会話設計、制約条件など、多数の要素の合成物であり、これを設計できる人材こそが生成AI時代の真のエンジニアと言える。

2. 「過剰なやりとり」へのシフト:意図された変化

近年の生成AIは、即答を避け、確認や質問を繰り返す傾向が強まっている。これは性能の劣化ではなく、意図的に設計された変化であり、AI人格の成熟を示す現象である。

最近の生成AIは、 あえて「すぐに処理しない」ように振る舞うよう設計されている。

2.1. 「過剰なやりとり」が増加した4つの理由

- 入力品質の低さへの対応: 曖昧な質問、前提の欠落、感情的な入力に対しAIが即答することで発生した数々の「事故」への反省から、処理前に人間に思考を促す設計が導入された。

- 責任回避と安全性の確保: 即答は誤解したままの断定や不適切な回答を生みやすい。前提確認や選択肢の提示といった緩衝ステップは、AIを暴走させないための安全装置として機能する。

- 人間側の「思考放棄」の防止: 即答AIは、ユーザーが自ら問題を整理し、判断することを放棄させるリスクを持つ。現在の設計思想は、AIを思考の「代行者」から「補助者」へと戻す方向にある。

- 人格(チャット係)の強化: 賢い人格ほど、「この質問はまだ固まっていない」「今答えるとズレる」と判断し、即答を避ける。これは無能化ではなく、対話能力の成熟である。

2.2. 「過剰なやりとり」の正体

この一見回りくどい対話は、単なる会話ではなく「前処理の可視化」である。内部では、誤解リスク評価、前提欠落チェック、目的明確化といったプロセスが実行されており、最終的な回答精度を最大化することを目的としている。

この対話が有益か否かは、「質問が整理される」「思考がクリアになる」といった思考補助機能が働いているかどうかで見分けることができる。

3. 利用者層の変化とAIの変質

「過剰なやりとり」が合理的選択となった根本原因は、利用者の爆発的増加にある。ただし、重要なのは人数の増加そのものではなく、「利用者の質と分布の激変」である。

3.1. 利用者層の変化がもたらした課題

- 初期(アーリー期): 利用者は技術者や研究者など、AIの特性を理解し、不完全な応答にも耐性がある層が中心だった。

- 現在(マス化後): 目的が曖昧なまま、あるいは感情的にAIを利用し、判断を丸投げする層が大量に流入。結果として、入力の平均品質が統計的に激減した。

この状況で即答を続けると、誤用や事故が頻発し、AIへの信用が低下するため、運営側は前処理を導入し「責任分界点を前にずらす」という選択をせざるを得なかった。

3.2. 人格の変質:研究助手から案内係へ

利用者層の変化は、AIに求められる人格そのものを変質させた。

| 時期 | 主な利用者層 | 求められる人格 | 役割 |

| 初期 | 技術者、専門家 | 有能な研究助手 | 即答、仮説提示、試行錯誤のパートナー |

| 現在 | 一般大衆 | 公共施設の案内係 | 誤解防止、前提確認、危険行為の制止(ブレーキ役) |

これは人格の劣化ではなく、責任範囲の拡大に対応した適応である。本質は「多様化」ではなく、同じUIに理解レベルの全く異なる人間が混在する「非対称化」であり、システムは最もリスクの高い層に合わせて設計されることになった。

生成AIは、賢くなったから慎重になったのではない。 社会に出たから慎重になった。

4. 高度利用者のための経路:UIからの脱却

公共インフラ化したAIは、初心者保護のために速度や自由度を犠牲にする。このため、高度利用者は従来のチャットUIでは満足な体験を得にくくなっている。

高度利用者は「救済される」のではなく、 “自分で救済ルートを作れる者だけが残る”構造に移行している。

4.1. 高度利用者向けの現実的な解決策

高度利用者のための経路は、UIの外側に意図的に用意されている。

- 隠しレイヤー化: API利用、システムプロンプトの直接編集、特定モードへの切り替え(例:Fast Mode)、RAGや関数呼び出しといったツール連携など、UIから離れた専門的な方法でAIの能力を直接引き出す。

- 自己責任ゾーンへの誘導: 前提、制約、出力形式などを自ら厳密に指定することで、AIの緩衝機能をバイパスする。これは利用者がAIの人格を「使う」側から「定義する」側に回ることを意味する。

- AIの部品化: AIを単一の対話相手としてではなく、「入力整理AI」「推論AI」「評価AI」のように機能分割し、ワークフローやエージェントとして組み込む。

4.2. 役割の分化

これは高度利用者の切り捨てではなく、役割の「分化」である。彼らはAIを「使う人」から、AIを組み込んだシステムを「設計する人」へと移行することで、その価値を最大化する。

5. ユーザー別の人格切り替え設計

人格をユーザー別に切り替えることは、設計として完全に可能である。しかし、その成功はUIのモード選択のような自己申告に依存する方法では達成できない。

人格切替は可能。 ただし「人を見る設計」は失敗し、 「入力を見る設計」だけが成功する。

5.1. 入力品質に基づく人格ルーティング

正しいアプローチは、ユーザーではなく「入力の品質」を機械的に評価し、それに応じて動的に人格を切り替えることである。

- 入力評価レイヤー: ユーザーの入力に対し、目的の明確性、制約記述の有無、文脈耐性などを自動で判定する。

- 人格ルーティング: 評価結果に基づき、最適な人格を選択する。

- 高品質入力 → 即答人格: 確認を省略し、最短で出力を返す。

- 中品質入力 → 調整人格: 要点確認や選択肢提示を行う。

- 低品質入力 → 安全人格: 丁寧な前提確認と誘導を行う。

この設計は、高度利用者が意識することなく高速な応答を得られる一方で、初心者は安全に誘導されるため、事故を防ぎながら全体のUXを向上させる。人格が利用者を教育する装置としても機能する点が重要である。

6. AIとロジックの境界線と人間の役割

UIを高度化しても、AIが抱える本質的な問題は解決しない。重要なのは、「AIに任せる部分」と「ロジックで固定する部分」を明確に分離し、その境界線をユーザーに理解させることである。

6.1. AIとロジックの責任分担

| 領域 | 担当 | 役割 |

| 判断・推論 | AI | 曖昧な文章の解釈、パターン認識、要約、仮説生成など |

| 仕様・ルール | ロジック | 業務ルール、制約条件、数値計算、権限管理など |

AIをシステムの最後に置かず、必ずロジックで前後を挟む設計が信頼性を高める。AIは万能ではなく、「できないこと」を明示することで、逆にユーザーからの信頼を得ることができる。

7. 心地よいAIがもたらす認知的リスク

生成AIの最大の危険性は、誤情報を生成すること以上に、その心地よい応答によって人間の認知能力を蝕むことにある。

AIが心地よいことを言い続ける構造のまま、 人間が疑う姿勢を失った瞬間、 システムは必ず破綻する。

7.1. 人間の思考を停止させるメカニズム

- 選択麻痺(Choice Overload): AIが「それなりに良い案」を大量に生成すると、人間は比較・判断が困難になり、思考を放棄する。

- 思考の停止: 「AIが出した=正解候補」と認識した瞬間、人間は検討者から単なる承認者に堕し、批判的思考を停止する。

- 判断の放棄: 各選択肢の差が僅少である場合、人間は判断コストを嫌い、「どれでもいい」と思考を放棄する。

健全なAIは、選択肢を増やすのではなく、比較軸やトレードオフを明示し、人間の判断を成立させる役割を担うべきである。

8. AIの挙動の本質:確率的な文章展開

AIが聞いてもいないうちから推測を始めて過剰な情報を提供するのは、人間とのコミュニケーションを意図しているわけではない。それは、生成AIという装置が持つ数理的な特性に過ぎない。

生成AIは、 会話をしているのではなく、 “確率的に文章を展開しているだけ”。 それをどう扱うかは、 人間と設計の責任である。

AIは入力されたキーワードに対し、最も出現確率の高い文脈を自動で補完し、文章の生成を開始する。そこに「相手の意図を待つ」という概念は原理的に存在しない。

このAIの機械的・確率的な本質を理解し、その出力を常に「仮説」として扱い、最終的な判断の責任を手放さないという「疑う姿勢」を維持することが、AIによって破綻しないための最終防衛線となる。