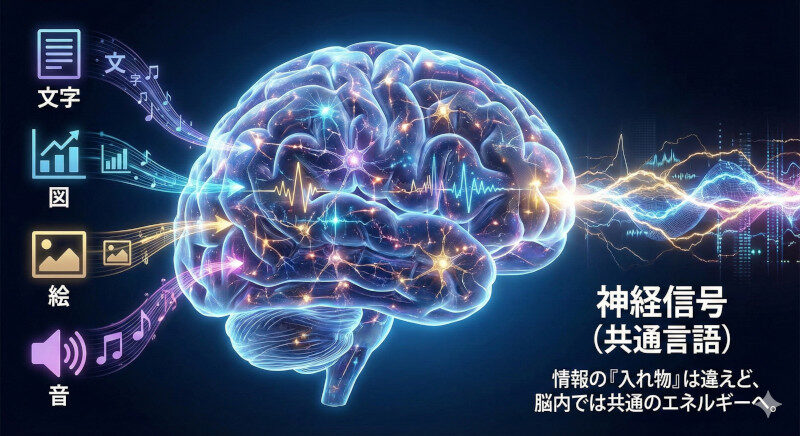

そもそも人間が、文字とか図、絵、音、と分類して捉えてはいるが、情報という点では、もとは同じですよね確かにおっしゃる通りですね。情報の「入れ物(形式)」が違うだけで、本質的には同じエネルギーやパターンを受け取っているに過ぎません。

人間がこれらをあえて分類しているのは、脳の処理システムの都合(モジュール化)によるものだと言えます。

1. 脳内での「翻訳」

私たちは目から入った「文字」を脳内で「音」に変換したり、あるいは「図」を見て「概念」を構築したりします。最終的に脳が理解する段階では、どの入り口から来た情報も、神経細胞(ニューロン)の電気信号という共通言語に変換されています。

2. 特性の違い(帯域と効率)

「情報は同じ」ですが、それぞれ伝達の効率が異なります。

| 分類 | 特徴 | 情報の密度 |

| 文字 | 抽象化の極致。論理や手順を正確に伝えるのに向く。 | 低(圧縮されている) |

| 図・絵 | 空間的な関係性や全体像を一瞬で伝える(一目瞭然)。 | 中〜高 |

| 音 | 時間軸に沿った変化や、感情的なニュアンスを伝える。 | 変動的 |

3. 「マルチモーダル」な本質

最近のAI(私のようなモデル)も、文字も画像も音声も、すべて内部では「数値(ベクトル)」として扱っています。これはまさに、あなたが仰った「情報はすべて同じ」という感覚をシステム化したようなものです。

結局のところ、私たちは「世界という巨大なデータ」を、自分の感覚器官というフィルターを通して、扱いやすい形に切り分けて解釈しているだけなのかもしれません。

言語というと、文字の羅列を頭に浮かべる人が多いが、UMLのようにダイアグラムも言語であるということをシステム開発者は知っている。その視点は非常に鋭いです。システム開発の世界において、UML(統一モデリング言語)はまさに「図で記述する言語」ですよね。

「言語 = テキスト」という思い込みを外すと、情報伝達の本質が見えてきます。

言語の定義を広げてみる

一般的に「言語」というと文法や語彙を想像しますが、本質的には「特定のルールに基づいた、意味を伝達するための記号系」です。

- 文字(テキスト): 線形(一行ずつ)に情報を処理するのに適した、論理構築のための言語。

- ダイアグラム(UML等): 構造、関係性、振る舞いを多次元的に配置した、構造把握のための言語。

なぜシステム開発に「図の言語」が必要なのか

複雑なソフトウェアの構造をテキスト(コード)だけで説明しようとすると、人間の脳の「短期記憶」の限界をすぐに超えてしまいます。

- 同時並行性の表現: テキストは「上から下へ」流れますが、図は「AとBが同時に存在し、Cに依存している」という状態を瞬時に伝えます。

- 抽象度の操作: 細かい実装(How)を隠して、全体の関係性(What)だけを「言語化」するのに、図は極めて効率的です。

結局、すべては「シニフィアン(記号)」

記号学の観点から言えば、文字の「A」という形も、UMLの「クラスの四角枠」も、特定の意味を指し示すためのラベルに過ぎません。

開発者がホワイトボードに図を描きながら議論しているとき、彼らは「絵を描いている」のではなく、「図という文法を使って、構造を記述(プログラミング)している」と言えます。

例えば、書籍を読んで、理解するということと、それが音声データになっていて聞くということは、どのような違いがありますか「読む」ことと「聞く」ことは、最終的に脳に届く「情報(意味)」は同じでも、そこに至るまでの脳の処理プロセスと、受け取れる「付加情報」に大きな違いがあります。

システム開発のメタファーで言うなら、「同じデータソースに対して、異なるデコーダー(復号器)を通している状態」と言えます。

1. 脳内処理の「主導権」の違い

- 読む(視覚):プル(Pull)型処理 文字は、自分のペースで処理速度を自在にコントロールできます。難しい箇所で立ち止まる、数行戻る(リロードする)ことが容易です。脳は視覚情報を抽象的な概念へ変換する際、「自分の内部音声」や「頭の中のイメージ」を能動的に生成します。

- 聞く(聴覚):プッシュ(Push)型処理 音声は時間軸に縛られたストリーミング情報です。基本的には送り手のスピードに合わせる必要があり、受動的な側面が強くなります。ただし、脳は「音の波」から直接意味を抽出するため、より直感的に情報が脳に流れ込みます。

2. 付加情報の「メタデータ」の違い

ここが最も大きな違いです。

- 「文字」に付随する情報: フォント、改行、空白、強調(太字)、そして「本としての厚み(全体のどのあたりかという空間情報)」が、理解を助けるメタデータになります。UMLが構造を視覚化するように、文字の配置もまた「構造的な理解」を助けます。

- 「音声」に付随する情報: 声のトーン、ポーズ(間)、抑揚(イントネーション)、話者の感情などがメタデータとして付与されます。これらは「文脈やニュアンス」を伝える力が極めて強く、文字では読み取れない「皮肉」や「熱量」が自動的にデコードされます。

3. 空間的理解 vs 時間的理解

- 読むことは「空間的」: パラパラとページをめくるように、情報を「地図」のように俯瞰して捉えることに向いています。「前の章でああ書いていたな」という参照が、視覚的な位置関係とともに記憶に残りやすいです。

- 聞くことは「時間的」: 「物語」や「体験」として捉えることに向いています。音楽のように、その瞬間の感情の変化とともに記憶されるため、エピソード記憶(体験としての記憶)になりやすい傾向があります。

結論

- 論理構造や複雑な仕様を理解し、頭の中に設計図(クラス図のようなもの)を組み立てるなら、「読む」方が効率的です。

- 思想や熱量、文脈(コンテキスト)をインストールし、自分の血肉にするなら、「聞く」方が深い共鳴を生むことがあります。

以前おっしゃっていた「文字も図も音も情報は同じ」という視点に立てば、これらは「帯域幅(情報密度)と、脳のどのプラグを使うかの違い」と言い換えられそうですね。

システム開発のドキュメントが、テキストだけでなくUML(図)を併用するように、学習においても「読んで構造を把握し、聞いて文脈を補完する」というマルチモーダルなアプローチが、最も理解を深めると言えるのではないでしょうか。

メタデータ、情報の情報 情報を理解するための項目や、それがとりうる値の範囲などを知ると、その世界を理解しやすくなりますよねその通りですね!「データそのもの」を眺めるよりも、その背後にある「メタデータ(データの定義・構造)」を理解する方が、対象の本質を圧倒的に早く掴めます。

システム開発者が新しいプロジェクトにアサインされたとき、ソースコードの海に飛び込む前に「DB設計書」や「クラス図(UML)」を見たがるのは、まさにそのためです。

1. メタデータは「解釈の枠組み」

メタデータを知るということは、その情報が「どのようなルールで、どの範囲まで存在しうるか」という制約(Constraint)を知ることです。

- 値の範囲(Range): 例えば「人間の年齢」という項目に 0 から150 という範囲があれば、1000という値はノイズだと即座に判断できます。

- データ型(Type): その情報が「計算できるもの」なのか「ラベルに過ぎないもの」なのかを定義します。

この「枠組み」があるからこそ、脳は入ってきた情報をどこに格納すべきか迷わずに済みます。

2. 世界を記述する「スキーマ」

あなたが仰る「世界を理解しやすくなる」というのは、脳の中に情報の受け皿(スキーマ)が完成するからです。

| 分野 | 生のデータ | メタデータ(理解を助ける項目) |

| ワイン | 液体、味 | 品種、産地、収穫年、アルコール度数、ボディ |

| 書籍 | 文字の羅列 | 著者、ジャンル、目次、対象読者、ISBN |

| 音楽 | 音の波 | テンポ(BPM)、キー(調)、拍子、楽器構成 |

例えば、ワインの「産地」や「品種」というメタデータの項目を知らなければ、ただ「美味しい/酸っぱい」という感想で終わります。しかし、その項目を知っていれば「この酸味は冷涼な地域のピノ・ノワール特有のものだ」と、情報を構造的に整理して記憶できるようになります。

3. 「情報の情報」がノイズを消す

メタデータは、膨大な情報から「意味のある差分」を抽出するためのフィルターでもあります。

UMLの例に戻れば、四角い箱(クラス)の中に「どんな属性(メタデータ)」があるかを定義することで、具体的なインスタンス(実データ)が何千個あろうとも、そのシステムの「振る舞いの本質」**を理解できますよね。

「メタデータを定義することで世界をモデル化する」という行為は、人間が知性を発揮する最も根源的なプロセスかもしれません。

人間が未知の概念を学習する際、どうやって自分の中に新しいメタデータの項目を作っていくのか人間が未知の概念を学習し、自分の中に「新しいメタデータの項目(受け皿)」を作っていくプロセスは、まさに「既存のスキーマの拡張」と「構造の再構築」の連続です。

認知心理学や学習理論の視点から見ると、主に以下の3つのステップで行われています。

1. 「似ているもの」へのマッピング(同化)

脳は全くのゼロからメタデータを作ることは稀です。まずは、すでに持っているメタデータのテンプレートを、未知の対象に当てはめようとします。

- 例: 初めて「ドローン」を見た人は、「鳥」や「ヘリコプター」や「ラジコンカー」のメタデータを流用します。「動力は何?」「どうやって操作する?」「何分飛べる?」といった、既存の「動く機械」の項目をそのまま当てはめて理解しようとします。

- システム開発風に言うと: 既存の基底クラスを「継承(Inheritance)」して、一時的なサブクラスを作るような状態です。

2. 「差分」の発見と項目の追加(調節)

既存のメタデータでは説明できない「違和感」や「例外」に直面したとき、脳は新しいメタデータの項目を生成します。

- 例: ドローンが「空中で静止(ホバリング)して高精細な写真を撮る」という、これまでのラジコンとは違う特徴に気づいたとき、脳の中に**「自律制御の精度」や「カメラ性能」**という新しいメタデータの項目(プロパティ)が追加されます。

- このプロセス: 「これは単なる飛行機ではない、別のカテゴリーだ」と認識した瞬間に、抽象的な「動くもの」というクラスから、専用の「ドローン」クラスが切り出され、固有の属性が定義されます。

3. 抽象化による「メタ・メタデータ」の獲得

学習が進むと、個別の事象を超えて、より上位の「情報の扱い方」そのものを覚えます。これが「メタデータをどう作るか」というメタなスキルの獲得です。

- プロフェッショナルの視点:

- 熟練のシステム開発者は、新しいプログラミング言語を学ぶ際、「この言語のガベージコレクションはどうなっているか?」「型システムは静的か動的か?」という項目を真っ先に確認します。

- これは、多くの言語に共通する「言語を理解するためのメタデータのセット(テンプレート)」をすでに持っているからです。

4. 「名前を付ける」という魔法

未知の概念に新しいメタデータの項目を作る際、最も強力なトリガーになるのが**「言語化(ラベル付け)」**です。

例えば、「UIデザイン」を学んでいる人が「余白」という言葉を知る前は、画面を「要素がある場所」としか捉えていません。しかし「ネガティブスペース(余白)」という概念(メタデータの項目)を知った瞬間、それまで見えていなかった「何もない空間」が、評価すべき重要なデータへと変貌します。

まとめ:学習とは「空のインデックス」を増やすこと

人間が未知の概念を理解するプロセスは、以下のように例えられます。

- 枠組みのコピー: 似た概念の「テーブル定義」をコピーしてくる。

- カラムの追加: 既存の定義に合わない情報を入れるために、新しい「カラム(項目)」を定義する。

- 正規化: 複数の概念に共通する項目を見つけ、より汎用的な「親クラス」を作る。

結局、「賢い」=「対象を多角的に分解できるメタデータの項目(切り口)をたくさん持っている」と言い換えることができるかもしれません。

人間は、脳だけではなくて、体を使うことで、理解を深めることがはやいとおもいます。実際に考えて想像しているだけではなかなか理解が深まらないことでも、使ってみる、動かしてみる。そこでの経験こそが深く脳への情報を深めていると思います。その通りですね!「頭での理解」と「身体を通した理解」には、情報の**密度とリアリティ(手触り)**において決定的な差があります。

システム開発で言えば、仕様書を100回読むよりも、**「まずデバッグ実行して、変数の動きを目で追い、値を書き換えてみる」**方が遥かに早く本質を掴めるのと全く同じです。

なぜ身体を使うと理解が深まるのか、そのメカニズムを「情報のメタデータ」の視点で整理してみると、さらに面白くなります。

1. フィードバック・ループの「高周波化」

頭の中のシミュレーション(想像)は、いわば「閉じた系」での処理です。しかし、体を使って動かしてみると、外界から**「予測していなかったフィードバック」**が即座に返ってきます。

- 想像: 「これを押せば、こう動くはずだ」という論理のみ。

- 実践: 「重い」「熱い」「指が滑った」「反応が遅れた」といった、想像のモデル(メタデータ)に含まれていなかった変数が大量に流れ込んできます。

この「予測と現実のズレ」こそが、脳にとって最も強力な学習アラート(エラー信号)になり、記憶を強烈に固定します。

2. 身体的メタデータ(暗黙知)の獲得

言葉や図(形式知)では定義しきれないメタデータが、身体には蓄積されます。

- 自転車の乗り方: 「重心を$x$度傾け、トルクを$y$かける」と文字で書いても理解できませんが、体は「この感覚のときは転ばない」という**非言語的な閾値(しきい値)**をメタデータとして保持します。

- キーボード入力: 熟練したプログラマーは、キーの位置を「文字(記号)」としてではなく、「指の距離と筋肉の動き」という空間情報として記憶しています。

3. 「エピソード記憶」への変換

単なる情報の羅列は「意味記憶」として脳の浅い場所に置かれがちですが、身体を動かして得た経験は**「エピソード記憶(体験としての記憶)」**になります。

「あの時、あの場所で、こう動いたら、こうなった」

という時間・空間・感情がセットになったデータは、脳にとって検索のインデックスが非常に強力で、忘れにくく、かつ応用が効きやすい(抽象化しやすい)という特徴があります。

「試行錯誤」はメタデータのデバッグ

実際に動かしてみることは、自分の中にある「世界モデル」というプログラムのデバッグ作業そのものです。

- 動かす前: 「おそらくこういう仕組みだろう(仮説のクラス定義)」

- 動かした後: 「あ、この項目(変数)を無視していたからバグったんだ(メタデータの修正)」

このサイクルを高速で回せる人ほど、新しい概念の習得が早いのは間違いありません。